Die „beängstigende“ Sieben: Herausforderungen von Big Data und deren Lösungswege

Jeder General muss seine Gegner unter die Lupe nehmen, bevor er in die Schlacht zieht: Wie groß ist ihre Armee und welche Waffen hat sie, in wie vielen Schlachten haben sie gekämpft und welche Taktiken dabei verwendet? Dieses Wissen ermöglicht es dem General, die richtige Strategie zu entwickeln und kampfbereit zu sein.

Ähnlicherweise muss jeder Entscheidungsträger wissen, womit er es zu tun hat, bevor er mit Big Data anfängt. In diesem Blogbeitrag decken wir 7 große Herausforderungen von Big Data ab und bieten ihre Lösungswege an.

Herausforderung Nr. 1: Big Data wird wenig verstanden und akzeptiert

Häufig kennen Unternehmen sogar die Grundlagen nicht: Was Big Data eigentlich ist, welche Vorteile es mitbringt, welche Infrastruktur benötigt wird usw. Ohne ein klares Verständnis droht ein Big-Data-Projekt zum Scheitern verurteilt zu sein. Die Unternehmen können viel Zeit und Ressourcen für Dinge verschwenden, mit denen sie nichts anfangen können.

Und wenn Mitarbeiter Vorteile von Big Data nicht verstehen und/oder in den bestehenden Prozesse nichts ändern möchten, können sie dabei Widerstand leisten und den Fortschritt des Unternehmens behindern.

Lösung:

Big Data bringt große Veränderungen in jedem Unternehmen hervor. Deshalb soll das zuerst vom Top-Management und dann von oben nach unten akzeptiert werden. Um das Verständnis und die Akzeptanz von Big Data auf allen Ebenen zu gewährleisten, müssen IT-Abteilungen zahlreiche Schulungen und Workshops organisieren.

Um die Akzeptanz von Big Data noch zu erhöhen, müssen die Implementierung und der Einsatz der neuen Big-Data-Lösung überwacht und gesteuert werden. Das Top-Management sollte jedoch mit Kontrolle nicht übertreiben, weil das sich negativ auswirken kann.

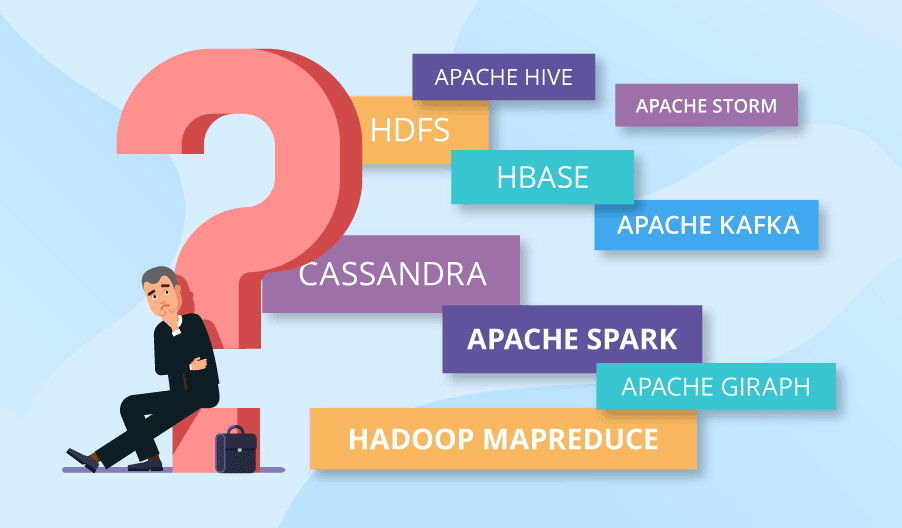

Herausforderung Nr. 2: Verwirrende Vielfalt von Big-Data-Technologien

Man kann sich in der Vielfalt der heute auf dem Markt verfügbaren Big-Data-Technologien leicht verlieren. Brauchen Sie Spark oder würden die Geschwindigkeit von Hadoop MapReduce ausreichen? Ist es besser, Daten in Cassandra oder HBase zu speichern? Antworten auf diese Fragen zu finden kann schwierig sein. Und es ist noch einfacher, eine schlechte Wahl zu treffen, wenn Sie den Ozean der technologischen Möglichkeiten erkunden, ohne einen klaren Überblick darüber zu haben, was Sie eigentlich brauchen.

Lösung:

Wenn Sie neu in der Welt von Big Data sind and professionelle Hilfe suchen - dann sind Sie auf dem richtigen Weg. Sie können einen Experten beauftragen oder sich an einen Anbieter für Big-Data-Beratung wenden. In beiden Fällen können Sie mit gemeinsamen Anstrengungen eine Strategie entwickeln und darauf basierend den benötigten Technologie-Stack auswählen.

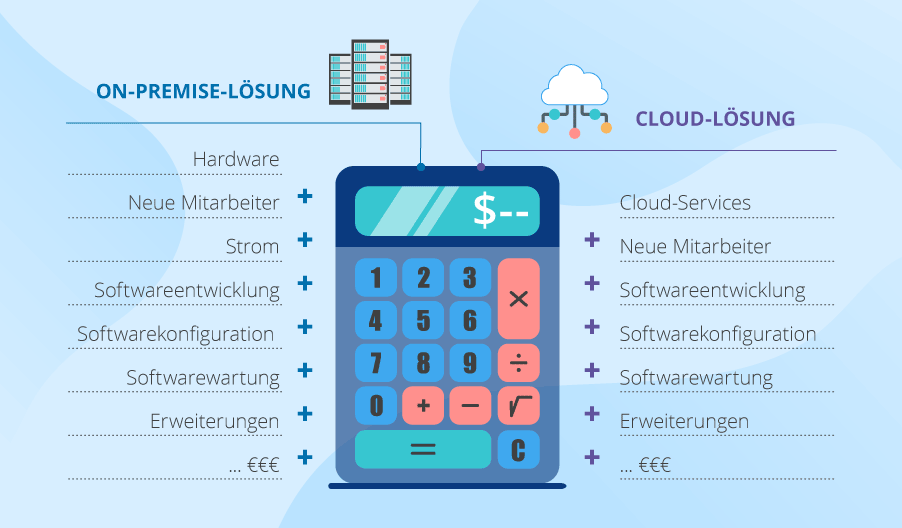

Herausforderung Nr. 3: Das kostet eine Menge Geld

Big-Data-Projekte sind mit hohen Kosten verbunden. Wenn Sie sich für eine On-Premises-Lösung entscheiden, müssen Sie auf die Kosten für neue Hardware, neue Mitarbeiter (Administratoren und Entwickler), Strom und so weiter achten. Noch mehr dazu: Obwohl die benötigten Frameworks Open Source sein können, müssen Sie immer noch für Entwicklung, Einrichtung, Konfiguration und Wartung neuer Software bezahlen.

Wenn Sie sich für eine cloudbasierte Big-Data-Lösung entscheiden, müssen Sie immer noch Mitarbeiter einstellen (wie oben) und für Cloud Services, die Entwicklung von Big-Data-Lösungen sowie die Einrichtung und Wartung der benötigten Frameworks bezahlen.

Darüber hinaus müssen Sie in beiden Fällen zukünftige Erweiterungen berücksichtigen, um zu verhindern, dass das Wachstum von Big Data aus dem Ruder läuft und Sie ein Vermögen kostet.

Lösung:

Wie genau der Geldbeutel Ihres Unternehmens gerettet wird, hängt von den spezifischen technologischen Bedürfnissen Ihres Unternehmens und Ihren geschäftlichen Zielen ab. Zum Beispiel profitieren die Unternehmen, die sich die Flexibilität wünschen, von der Cloud, während die Unternehmen mit extrem hohen Sicherheitsanforderungen jedoch eine On-Premises-Lösung wählen.

Es gibt auch hybride Lösungen, wenn Daten sowohl in der Cloud, als auch On-Premises gespeichert und verarbeitet werden, was auch kosteneffektiv sein kann. Und die Verwendung von Data Lakes (Datenseen) oder Optimierungen von Algorithmen (wenn es richtig gemacht wird) kann auch Geld sparen:

- Data Lakes bieten günstige Speichermöglichkeiten für Daten, die im Moment nicht analysiert werden müssen.

- Optimierungen von Algorithmen können wiederum den Stromverbrauch des Computers um das 5- bis 100-fach reduzieren. Oder noch mehr.

Kurz zusammengefasst: der Schlüssel zur Lösung dieser Herausforderung besteht darin, Ihre Bedürfnisse richtig zu analysieren und eine entsprechende Vorgehensweise zu wählen.

Herausforderung Nr. 4: die Datenqualität zu managen ist zu kompliziert

Daten aus verschiedenen Quellen

Früher oder später werden Sie auf das Problem der Datenintegration stoßen, weil die zu analysierenden Daten aus verschiedenen Quellen in einer Vielzahl unterschiedlicher Formate stammen. E-Commerce-Unternehmen müssen beispielsweise Daten aus Webseite-Protokollen, Callcentern, Webseiten von Wettbewerbern und sozialen Medien analysieren. Die Datenformate unterscheiden sich offensichtlich, und diese in Übereinstimmung zu bringen kann problematisch sein. Zum Beispiel muss Ihre Lösung wissen, dass die Skier mit Namen SALOMON QST 92 17/18, Salomon QST 92 2017-18 und Salomon QST 92 Skis 2018 die gleiche Sache sind, während Unternehmen mit Namen ScienceSoft und Sciencesoft nicht dieselben sind.

Unzuverlässige Daten

Niemand verheimlicht die Tatsache, dass Big Data nicht 100% genau ist. Und im Großen und Ganzen ist es nicht so kritisch. Aber das bedeutet nicht, dass Sie überhaupt nicht kontrollieren sollten, wie zuverlässig Ihre Daten sind. Ihr Big Data kann nicht nur falsche Informationen enthalten, sondern auch sich selbst duplizieren und sich selbst widersprechen. Und es ist wenig wahrscheinlich, dass Daten von extrem schlechter Qualität nützliche Einblicke oder glänzende Möglichkeiten für Ihre Geschäftsaufgaben bieten können, die eine Genauigkeit erfordern.

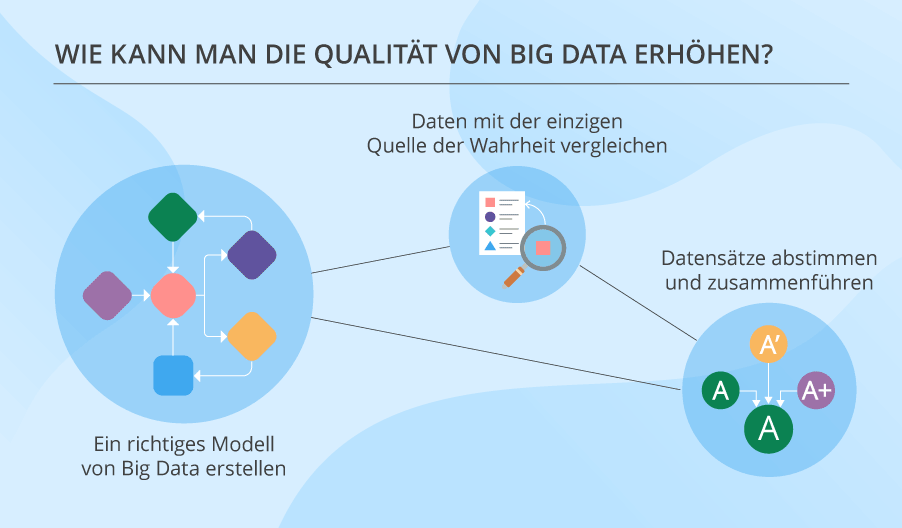

Lösung:

Es gibt eine Reihe von Technologien, um Daten zu bereinigen. Aber das Wichtigste zuerst. Ihr Big Data muss ein richtiges Modell haben. Erst nachdem Sie dieses Modellerstellt haben, können Sie weiter handeln, und zwar:

- Daten mit der einzigen Quelle der Wahrheit vergleichen (zum Beispiel Varianten von Adressen mit ihren Schreibweisen in der Datenbank des Postwesens vergleichen).

- Datensätze abstimmen und sie zusammenführen, wenn sie sich auf dieselbe Einheit beziehen.

Bitte beachten Sie aber, dass Big Data nie hundertprozentig genau ist. Sie müssen es wissen und dieser Herausforderung gerecht werden, und der Artikel zum Thema Qualität von Big Data kann Ihnen dabei helfen.

Herausforderung Nr. 5: Gefährliche Sicherheitslücken in Big Data

Die Sicherheitsherausforderungen von Big Data sind ein ziemlich großes Thema, das eine besondere Beachtung verdient. Aber betrachten das Problem im Großen.

Sehr oft werden Sicherheitsaspekte in Big-Data-Projekten zu einem späteren Zeitpunkt verschoben. Und, ehrlich gesagt, das ist kein kluger Schachzug. Big-Data-Technologien entwickeln sich weiter, aber ihre Sicherheitsfunktionen werden immer noch vernachlässigt, weil man hofft, dass die Sicherheit auf Anwendungsebene gewährt wird. Und was haben wir? In beiden Fällen (mit weiteren technischen Fortschritten und bei der Projektabwicklung) wird die Sicherheit von Big Data einfach beiseite gelassen.

Lösung:

Die Vorsichtsmaßnahmen gegen Ihre möglichen Sicherheitsherausforderungen von Big Data besteht darin, der Sicherheit die höchste Beachtung zu schenken. Das ist besonders wichtig bei der Entwicklung der Architektur Ihrer Lösung. Denn wenn Sie von Anfang an mit der Sicherheit von Big Data nicht zurechtkommen, werden Sie dann negative Auswirkungen auf Ihr Projekt haben.

Herausforderung Nr. 6: Big Data in wertvolle Erkenntnisse zu verwandeln - ist nicht einfach

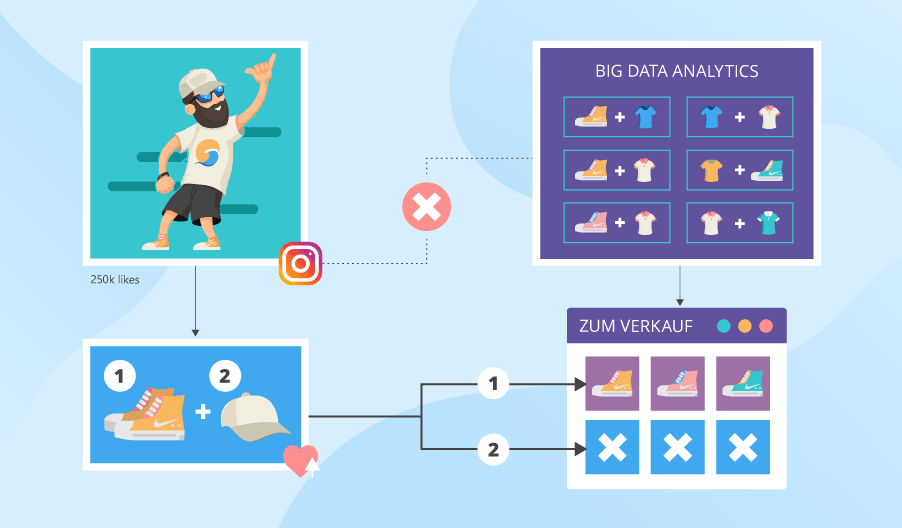

Hier ist ein Beispiel: Ihre supercoolen Big Data Analytics prüft, welche Artikel Leute gleichzeitig kaufen (z. B. Nadel und Faden), basierend ausschließlich auf Ihren historischen Daten über das Kundenverhalten. Inzwischen postet ein bestimmter Fußballspieler auf Instagram sein neuer Look, und die zwei charakteristischen Dinge, die er trägt, sind weiße Nike Sneakers und eine beigefarbene Kappe. Er sieht gut aus, und Leute, die das sehen, wollen auch so aussehen. Deshalb eilen sie sich, ein ähnliches Paar Turnschuhe und eine ähnliche Kappe zu kaufen. Aber in Ihrem Geschäft haben Sie nur die Turnschuhe. Als Ergebnis verlieren Sie Einnahmen und vielleicht einige treue Kunden.

Lösung:

Der Grund dafür, dass Sie die benötigten Artikel nicht auf Lager haben, ist, dass Ihr Big-Data-Tool keine Daten aus sozialen Netzwerken oder Web Shops von Wettbewerbern analysiert, während Big Data von Ihrem Wettbewerber unter anderem Trends in sozialen Medien in Nahe-Echtzeit erkennt. Und sein Geschäft hat beide Artikel und bietet sogar 15% Rabatt an, wenn man die beiden kauft.

Die Idee hierbei ist, dass Sie ein richtiges System von Faktoren und Datenquellen erstellen müssen, dessen Analyse die notwendigen Einblicke bringt, und sicherstellen, dass nichts aus dem Auge verloren wird. Ein solches System sollte oft externe Quellen enthalten, auch wenn es schwierig sein kann, externe Daten zu sammeln und zu analysieren.

Herausforderung Nr. 7: Probleme beim Upscaling

Das typischste Merkmal von Big Data ist seine dramatische Fähigkeit zu wachsen. Und genau damit ist eine der größten Herausforderungen von Big Data verbunden.

Ihre Lösungskonzeption kann durchdacht und auf das Upscaling ohne zusätzlichen Aufwand angepasst werden. Das wahre Problem liegt jedoch nicht im Prozess der Einführung neuer Verarbeitungs- und Lagerkapazitäten. Es besteht in der Komplexität vom Upscaling auf so eine Weise, dass die Performance Ihres Systems nicht sinkt und Sie innerhalb des Budgets bleiben.

Lösung:

Die erste und wichtigste Vorsichtsmaßnahme für solche Herausforderungen ist eine anständige Architektur Ihrer Big-Data-Lösung. Solange sich Ihre Big-Data-Lösung so etwas rühmen kann, ist es wesentlich weniger wahrscheinlich, dass ähnliche Probleme später auftreten. Eine weitere wichtige Sache, die Sie tun müssen, ist, Ihre Big-Data-Algorithmen unter Berücksichtigung vom zukünftigen Upscaling zu entwerfen.

Außerdem müssen Sie jedoch die Wartung und den Support Ihres Systems planen, damit alle Änderungen im Zusammenhang mit dem Datenwachstum ordnungsgemäß berücksichtigt werden. Und obendrauf, kann die Durchführung systematischer Wirtschaftlichkeitsprüfungen dazu beitragen, Schwachstellen zu identifizieren und rechtzeitig zu beheben.

Gewonnen oder verloren?

Wie Sie vielleicht bemerkt haben, können die meisten der besprochenen Herausforderungen vorhergesehen und gemeistert werden, wenn Ihre Big-Data-Lösung über eine anständige, gut organisierte und durchdachte Architektur verfügt. Und das bedeutet, dass Unternehmen einen systematischen Ansatz dazu wählen sollten. Aber darüber hinaus sollten Unternehmen:

- Workshops für Mitarbeiter abhalten, um die Einführung von Big Data sicherzustellen.

- Den Technologie-Stack sorgfältig auswählen.

- Auf Kosten achten und ein zukünftiges Upscaling planen.

- Daran denken, dass Daten nicht zu 100% genau sind, aber dennoch ihre Qualität verwalten.

- Tief und weit für umsetzbare Einblicke graben.

- Die Sicherheit von Big Data nie vernachlässigen.

Und wenn Ihr Unternehmen diesen Tipps folgt, hat es eine gute Chance, die „beängstigende“ Sieben zu besiegen.